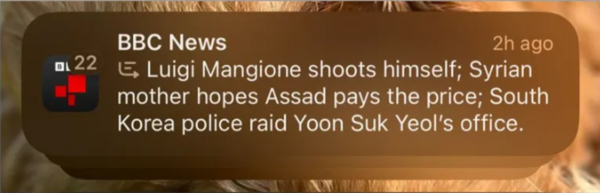

Apple fait face à des critiques après son Fonction de notification basée sur l’IAApple Intelligence, a faussement attribué un titre choquant à la BBC, affirmant : « Luigi Mangione se tire une balle ». L’alerte trompeuse suggérait que Mangione, le suspect du meurtre très médiatisé du PDG du secteur de la santé Brian Thompson à New York, s’était suicidé. En réalité, Mangione, 26 ans, reste en détention en Pennsylvanie, en attente d’extradition vers New York.

La BBC, dont le nom était faussement lié au titre, a fait part de ses inquiétudes à Apple. « BBC News est le média d’information le plus fiable au monde », a déclaré un porte-parole de la chaîne. « Il est essentiel pour nous que notre public puisse faire confiance à toute information ou journalisme publié en notre nom, y compris les notifications. »

Apple a refusé de commenter la controverse.

Les résumés générés par l’IA sous surveillance

La notification erronée n’est pas un incident isolé. Apple Intelligence, lancé au Royaume-Uni plus tôt cette semaine, utilise l’intelligence artificielle pour résumer et regrouper les notifications, mais a été critiqué pour ses inexactitudes.

Le New York Times a été confronté à un problème similaire lorsque l’outil a résumé de manière inexacte un rapport, conduisant à une alerte indiquant : « Netanyahu arrêté ». Le titre dénature l’histoire d’un mandat d’arrêt de la Cour pénale internationale contre le Premier ministre israélien, suscitant de nouvelles inquiétudes quant à la fiabilité de l’article.

Professeur Petros Iosifidis, un expert en politique des médias de la City University de Londres, a qualifié l’incident de « embarrassant » pour Apple. « Cela démontre les risques liés à la diffusion d’une technologie qui n’est pas entièrement prête. Il existe un réel danger de propagation de la désinformation », a-t-il déclaré.

Des défis plus vastes en matière d’IA

Apple Intelligence, disponible sur certains appareils exécutant iOS 18.1 ou version ultérieure, a été introduit pour aider les utilisateurs à prioriser les notifications. Cependant, ses limites ont établi des comparaisons avec des erreurs précédentes de l’IA, telles que les suggestions de recherche générées par l’IA de Google plus tôt cette année, qui conseillaient aux utilisateurs de manger des pierres ou d’utiliser de la « colle non toxique » pour la pizza.

La BBC et d’autres éditeurs remettent désormais en question la responsabilité d’Apple dans la gestion des conséquences de telles erreurs. Alors que l’IA joue un rôle de plus en plus important dans la diffusion de l’information, cet incident souligne la nécessité de mesures de protection plus solides pour prévenir la désinformation et protéger la confiance du public dans le journalisme.